近日,电子系信息认知与智能系统研究所张超团队研发的 SALMONN 系列多模态大模型迎来重要扩展,涵盖新一代 video-SALMONN 2/2+ 音视频理解大语言模型、推理增强型 video-SALMONN-o1(ICML 2025)、高帧率视频理解架构 F-16(ICML 2025),以及面向无文本泄漏的音视频理解基准 AVUT(EMNLP 2025)。该系列成果在模型方法与评测体系两方面同时取得进展,巩固了 SALMONN 系列大模型在音视频理解领域的领先优势。

本次的主要亮点进展包括:

• video-SALMONN 2+ 在视频字幕生成与问答等综合任务中表现卓越,位居多项权威榜单前列;

• video-SALMONN-o1 聚焦复杂音视频推理,尤其适用于脱口秀、学术报告等复杂音视频理解场景;

• F-16 高帧率架构在体育赛事等高速动态视频中展现出细粒度信息捕捉能力;

• AVUT 基准提出无文本泄漏的音视频评测范式,更系统地衡量模型对真实世界多模态线索的理解水平。

SALMONN 系列的持续迭代,体现了我系团队在多模态大模型与评测体系方面的长期探索与学术积累。未来,研究团队将进一步推动相关技术在教育、科研、媒体和智能体等多领域的落地应用。

图像由Nano-Banana生成

能准确叙述音视频的video-SALMONN 2+

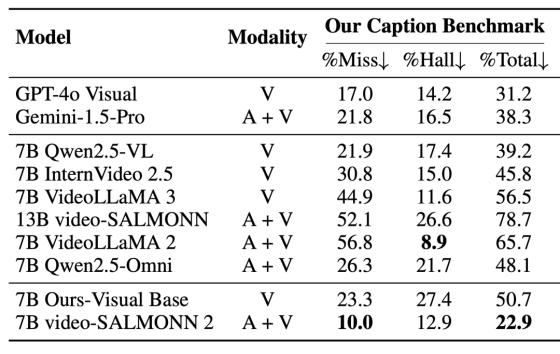

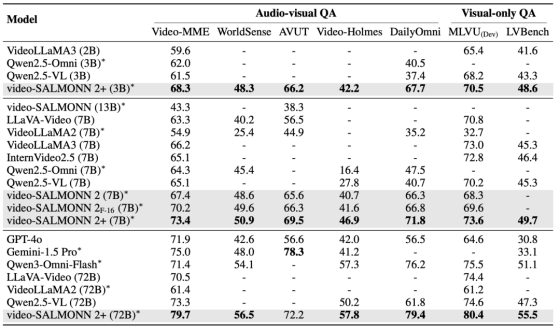

video-SALMONN 2+ 是系列最新的旗舰模型。现有视频大语言模型在生成描述时常出现信息缺失或幻觉,video-SALMONN 2 针对这一问题提出改进,强调生成描述的完整性与准确性。研究团队基于“原子事件”构建了视频描述质量评估体系,并通过多轮直接偏好优化(MrDPO)显著提升模型性能。在优化过程中,引入了两项关键正则化策略:一是更新并重新初始化低秩自适应(LoRA)模块,二是引入真实描述作为监督信号。实验结果显示,该模型在视频描述任务中全面超越包括 GPT-4o 和 Gemini 1.5 Pro 在内的主流模型,展现了强大的研究潜力与应用前景。

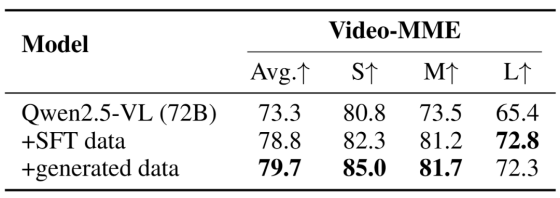

研究团队进一步验证了自举式数据使用的新范式:基于模型大规模合成高质量视频描述语料,并将其用于新一轮模型训练,不仅有效保持了描述能力的精度与覆盖度,同时在视频问答等综合音视频理解任务上带来显著增益。

在系统性评测中,video-SALMONN 2+ 在多项权威音视频测试基准上取得领先:涵盖音视频类 Video-MME、WorldSense、AVUT、Video-Holmes、DailyOmni,以及静音视频类 MLVU、LVBench等。其中 72B 规模模型的总体表现超过了 GPT-4o 与 Google Gemini 1.5 Pro 等闭源商业模型。

值得注意的是,由于对音频模态的同步建模与融合,video-SALMONN 2+ 在 Video-MME 等评测中的“无字幕”(端到端真实系统)与“有字幕”(外接人工标注或商用语音识别生成的理想字幕)两种设置下的性能差距小于 2%。这一结果表明,音视频跨模态协同能够显著增强语义理解的稳健性与完整性,尤其在无人工字幕视频与机器人等场景中展现出明确优势。

研究团队以 Qwen 2.5-VL 7B 为基础构建音视频模型,依照前述音视频多任务训练流程并结合 MrDPO 推理对齐策略,得到 video-SALMONN 2+ 7B。在此基础上,团队利用该模型对更大规模的原始音视频语料进行高质量描述标注,形成扩展训练集;以此为数据源,分别训练基于 Qwen 2.5-VL 3B/72B 的音视频大模型,最终获得 video-SALMONN 2+ 3B/72B 两个规格。实验结果表明,相较仅使用人工原始标注数据的基线方案,上述自举式数据扩展显著提升了模型的视频理解与问答综合能力。

在 Video-MME 基准上的消融研究进一步验证了该技术路径的有效性:高描述能力的video-SALMONN 2模型能够作为高质量训练数据的生成器,稳定产出细粒度、低幻觉的视听描述,从而为后续更大规模或更轻量化的音视频模型提供可靠的数据基座,促进迭代式训练—数据再标注—性能跃迁的良性循环。该结果表明,基于生成增强的数据闭环,可在不依赖额外人工标注成本的前提下,系统性推动音视频理解模型的持续进化。

推理增强的音视频理解模型

video-SALMONN-o1(ICML 2025)

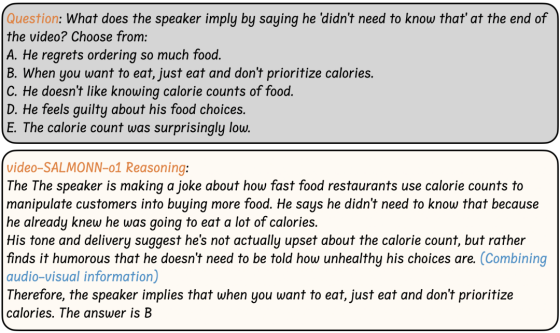

面向长时、多层级语义场景,o1 通过强化跨模态证据聚合与上下文建模,系统提升因果、时序与指代等高阶推理能力,促进对脱口秀、学术报告等复杂视频内容的深层理解。

问题: 说话者在视频结尾说他“并不需要知道那个”时,暗示了什么?从以下选项中选择: A. 他后悔点了这么多食物。 B. 想吃就吃,不要把卡路里放在首位。 C. 他不喜欢知道食物的卡路里数。 D. 他对自己的食物选择感到内疚。 E. 卡路里含量出乎意料地低。

video–SALMONN–o1 推理:

说话者在开玩笑,谈到快餐店如何利用卡路里标注来操纵顾客购买更多食物。他说自己不需要知道那个,因为他早就知道自己会摄入很多卡路里。 他的语气和表达方式表明,他并不是真的对卡路里数感到不满,而是觉得好笑:根本不需要别人告诉他自己的选择有多不健康。(此处结合视听信息) 因此,说话者所暗示的是:想吃就吃,不要把卡路里当成优先考虑。答案是 B

问题: 这个视频里有什么笑话以及为什么好笑?请逐步详细分析

video-SALMONN-o1推理:

笑点在于:美国副总统乔·拜登写了一本自传。

说话者(很可能是个喜剧演员或观众)说他觉得这本书比实际好得多。

这很有趣,因为它利用了一个常见的观念——政治人物往往会把自己描绘得比他们真正值得的更正面。

说话者暗示拜登的自传好得令人难以置信,这是一种对情境的幽默夸张。

问题: 双胞胎研究如何分离TBI(创伤性脑损伤)对痴呆风险的影响。请逐步分析。

video-SALMONN-o1推理:

问题在于双胞胎研究如何分离TBI(创伤性脑损伤)对痴呆风险的影响。我们需要明确该研究中有哪些关键要素,能够帮助把 TBI 的作用与其他影响痴呆的因素区分开来。

讲者提到,该研究采用“双胞胎配对”设计,也就是说比较双胞胎个体。这意味着研究重点在于控制遗传因素和共同的环境因素。

讲者强调,研究中的双胞胎在 TBI 上是不一致的(即一人有 TBI,另一人没有),在痴呆发病上也是不一致的(即一人发展为痴呆,另一人没有)。这种设计使研究者能够控制早期的遗传和环境暴露因素,因为这些在双胞胎之间是相似的。

通过比较在 TBI 经历和痴呆结果上不同的双胞胎,研究就能隔离出 TBI 对痴呆风险的影响。如果 TBI 是一个重要的风险因素,我们就会预期:有 TBI 的双胞胎更容易发展为痴呆,而没有 TBI 的双胞胎则相对较少出现痴呆。

在脱口秀、学术报告等复杂视频场景中,深层理解不仅依赖于音频与视觉的联合建模,更要求在此基础上开展多步推理。video-SALMONN-o1 作为首个推理增强的开源音视频大语言模型,相较于同类系统的“直接给答”范式,可基于同步视听输入,基于证据逐步推理并给出结论,从而实现结论与论证的一致性与可解释性。实验表明,面向数学/编程的文本推理优化,或以图—文为主的推理范式,难以有效迁移至音视频理解。相比之下,video-SALMONN-o1通过原生视听过程监督与强化学习构建稳健的推理链条,拓展了多模态推理的适用边界,促进模型以“推理为核心”更全面地把握物理世界中的事件的来龙去脉。

核心算法process DPO

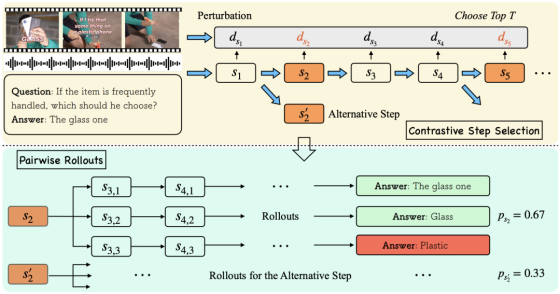

pDPO rollout和contrastive step selection示意图

Process DPO (pDPO) 是video-SALMONN-o1核心提出的一种新型的训练方法。和传统过程奖励模型(PRM)一样,pDPO目标是获得每一个推理步骤的反馈来实现step level的优化。然而,音视频模型本身的自我检查的能力较弱,传统的PRM很难直接套用在音视频模型上来获得有效的奖励。

因此,和传统PRM不同的是,pDPO采取了偏好优化的路线,在每一步开始的时候,采样两个不同的下一步(即 s k 与 s’ k ),之后对这两个可能的下一步分别进行推理展开(rollout),根据展开结果的准确率,比较两条可能的下一步的优劣,修改DPO损失函数到每一步的级别进行优化。

对于大量rollout带来的计算成本增加,我们观察推理步骤可以发现,只有某几步较为关键,且错误的关键步骤不确定性往往较高。因此,我们通过加微小扰动看输出变化的思路,估计每一步的不确定性,决定哪些步需要被优化,从而大大降低计算成本。

高帧率视频理解的F-16模型(ICML 2025)

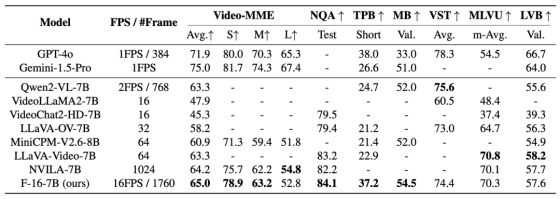

面向需要细粒度时序线索的场景(如高速运动、镜头快速切换等),F-16 聚焦高帧率视频的高效理解。人类感知可在远高于 30 fps 的速率下整合运动与变化信息;然而,现有多数视频大语言模型通常以低采样率抽取少量图像帧后接入 LLM,导致关键时序细节缺失,尤其在高动态任务上表现受限。简单地提升输入帧率虽可缓解信息不足,却会带来难以承受的计算开销,因此亟需在时序信息保真与可计算性之间取得平衡的结构性设计。

为此,F-16 提出一条“轻量对齐、保留视觉先验、联合压缩”的技术路线:研究表明,使用复杂连接结构进行跨模态对齐,易造成视频语义稀释与与语言空间错配,进而恶化整体性能。F-16 从单帧对齐器出发进行最小侵入式扩展,在不破坏图像模型预训练知识的前提下,将多帧特征联合输入对齐器,实现语义对齐 + 时序保真压缩的统一;由此构建的多帧视频对齐器既提升了高帧率场景下的关键信息通过率,又保持了推理链路的高效性与稳定性。

在系统评测中,F-16 在通用视频理解基准上达到与同期同规模开源纯视觉模型的SOTA 水平,在更强调时序建模的基准(如运动与事件定位)上取得领先表现。该结果表明:通过“多帧联合对齐 + 语义压缩”的设计,可以在计算预算可控的条件下,有效捕捉决定性瞬间,为高帧率视频理解提供具有可扩展性的范式。

FPS = 16 FPS = 1

FPS = 16 FPS = 1

在四项体育专项评测(篮球、足球、体操、跳水)中,基于相同训练数据进行任务微调的高帧率模型在整体效果上显著优于对应的低帧率模型,并在同等设置下超过 GPT-4o、Gemini 1.5 Pro 等领先闭源系统,进一步佐证了高帧率时序线索在高速动态场景中的关键作用与性能红利。

综上,研究系统性验证了高帧率信息在通用视频理解中的方法论价值,为面向体育赛事、自动驾驶等高动态场景的后续模型设计与高帧率高效建模策略(如多帧联合对齐与可计算性约束下的时序压缩)的深入探索提供了坚实技术基础与经验依据。

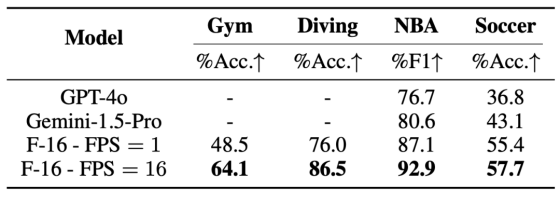

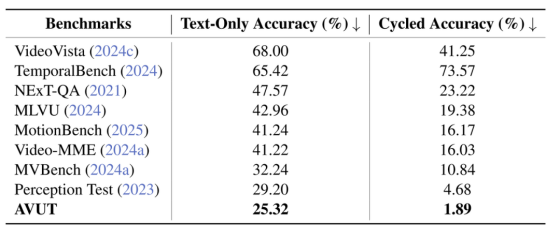

低文本泄漏的音视频评测基准 AVUT(EMNLP 2025)

AVUT 面向通用场景的音视频理解,覆盖信息检索、内容计数、事件定位与匹配、说话人日志等多类任务。多项子任务对非语音型音频事件与纯视觉线索具有依赖性,单纯的语音转文本难以承载全部信息,这从方法论上突出了音视协同表征与推理的必要性。

当前评测中一个常被忽视的系统性偏差是文本捷径(text shortcut):在若干公开基准上,模型在不接触视频内容的前提下,仅凭题干与选项即可获得不低的正确率(下表中GPT-4o实验结果的Text-only Accuracy)。这意味着部分高分并非真正反映对多模态线索的理解能力,而是对数据分布规律或文本知识的利用。为缓解上述问题,AVUT 在设计上同时强调以下两点:

• 模态均衡:在题干构造、可用证据与任务目标上,平衡音频、视频与文本三类模态的贡献,降低对任一单模态的过度依赖;

• 捷径抑制:通过题目与候选答案的构造削弱文本启发式与统计偏置,促使模型必须调取并整合音—视证据。

此外,AVUT提出了Cycled Accuracy 指标:对每道题的候选答案进行循环重排(如 ABCD、BCDA、CDAB、DABC),并仅在模型对全部排列均给出相同正确答案时计为正确。该指标有效抑制了由选项位置偏好(如“拿不准倾向选 C”)导致的虚高分数,更可靠地刻画模型的稳健判别能力与证据一致性。实证结果显示,AVUT 能显著降低“文本短路”与“位置偏好”的影响,从而更公正地评价真实的音视频理解水平。

随着 video-SALMONN 2+ 在多项基准上取得领先、video-SALMONN-o1 推理增强路径的验证落地、F-16 高帧率架构的系统升级,以及以音频证据为核心设计原则的 AVUT 基准发布,SALMONN 系列已形成贯通模型方法和评测体系的闭环框架,在效率和效果两维度实现协同提升。该体系不仅提升了开源视频理解的性能上限,也为学术与产业实践提供了可复现的技术路线与可比对的评价标准。展望未来,SALMONN 系列将持续迭代,围绕更强的多模态建模能力与更完备的生态构建,拓展在复杂开放环境中的泛化与可靠性。

SALMONN系列开源地址:https://github.com/bytedance/SALMONN

论文地址:

video-SALMONN 2:https://arxiv.org/abs/2506.15220

video-SALMONN-o1:https://openreview.net/pdf?id=y62fhuA69I

F-16:https://openreview.net/pdf?id=3H7qAT9Qow

AVUT Benchmark:https://arxiv.org/abs/2503.19951

张超个人简介

张超,清华大学电子工程系助理教授、博士生导师,上海人工智能实验室双聘青年科学家。研究方向为多模态大模型、脑信号解码与大脑健康。张超2017年于剑桥大学获博士学位,曾任剑桥大学副研究员、京东AI语音组联合负责人、Google公司高级研究科学家,多项成果被工业界大规模应用,并5次获国际会议最佳学生论文奖。兼任伦敦大学学院脑科学部荣誉副教授、中文信息学会语音信息专委会副秘书长等职务。

清华大学电子工程系多媒体信号与智能信息处理实验室在医工交叉和语音处理领域有长期积淀。实验室的张超研究小组成立于 2022 年,专注于多模态大语言模型、脑信号解码与大脑健康研究。

供稿|信息认知与智能系统研究所

编辑|陶旋姿

审核|汪 玉 沈 渊 李冬梅