清华大学电子工程系方璐教授课题组提出了光子深度学习架构与芯片,突破了深层光计算的误差累积难题,首次实现了百层亿级参数的深度光子神经网络。

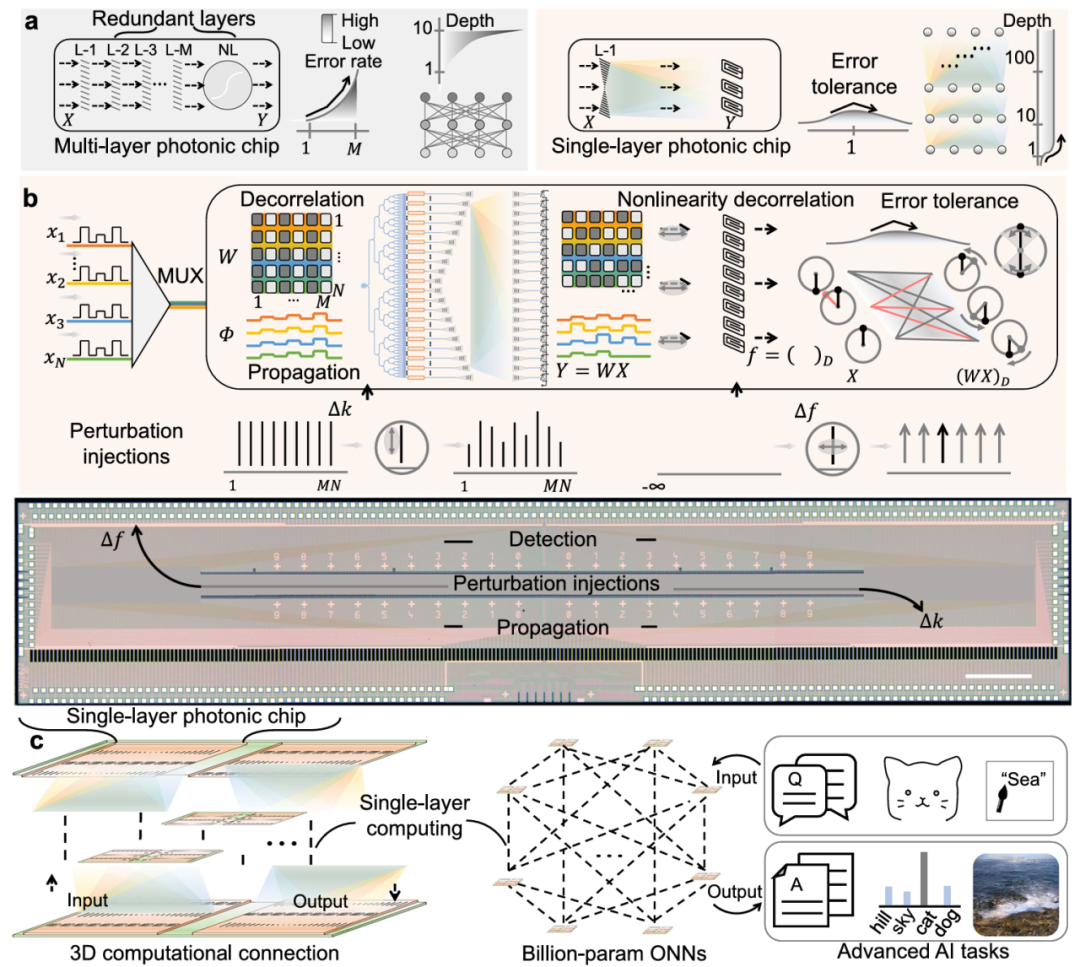

图1. 光子深度学习计算架构与芯片

人工智能发展对算力的需求,呈现远超摩尔定律增长的趋势。光计算以光子为信息载体,以光的受控传播实现计算,在算力和能效上具备突出的优势。然而,光计算长期面临数值误差在深层传播中快速放大的困境,难以支撑大规模深层计算。

本研究刻画了片上光子神经网络的传播冗余特性,构建了可量化的误差传播模型,提出了可极联的单层光计算(SLiM)架构。团队基于光传播的带宽优势提出空间光谱耦合的计算芯片架构,将片上单路光信息通量扩容至256通道,单路光计算带宽达THz;构建片内主动注入扰动计算结构,打破光路固有波长关联制约,仅需单层传播即可实现信息通量内任意规模、任意维度矩阵计算;针对深度级联难题,提出层间探测扰动非线性激活机制,从物理层面切断误差递增链条。任意矩阵映射能力与深度级联机制有机融合,进一步支持卷积核变换、注意力算子等计算单元的自由构建。借此,深度光神经网络中的物理传播层和非线性层被压缩为单次光传播与探测激活,保持光计算速度规模优势的同时有效抑制模型误差累积。

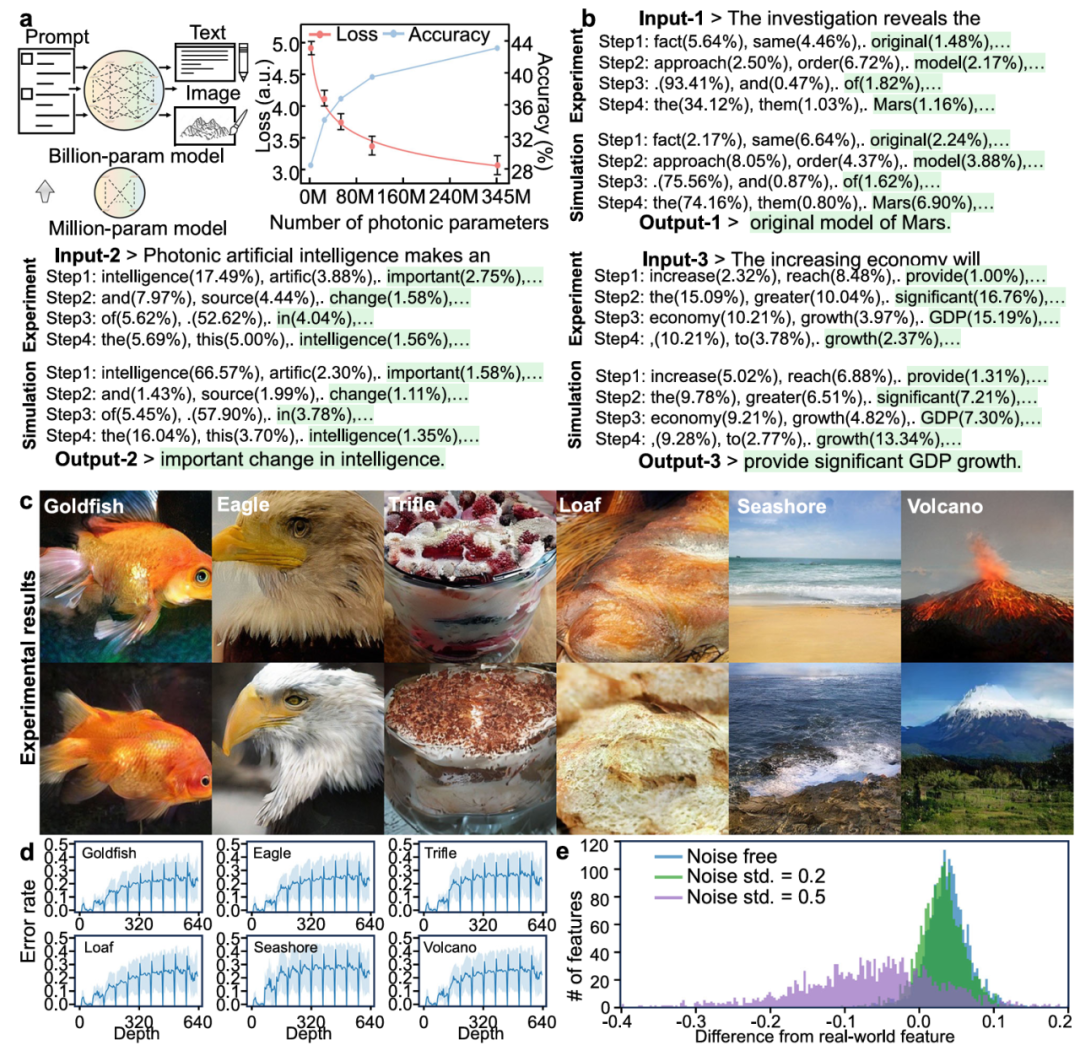

基于SLiM架构及芯片,团队构建了 100 层的光子深度网络,实现了ImageNet-1000 完整数据集分类,准确率为85.2%;进一步实现了 384层 与 640 层的Transformer 光子大模型,参数规模为0.345B与0.192B,支撑文本生成与图像生成,如图2所示。

图2. 光子大模型计算

本工作突破了误差累积这一长期困扰深度光计算的核心瓶颈,提出了可在物理层面抑制深度误差传播的光计算机制,并实现了可扩展至百层的深度光神经网络新架构,探索了光计算领域层数扩展的有效路径,有望为未来人工智能大模型、复杂智能任务提供光子算力支撑。相关研究以“Hundred-layer photonic deep learning”为题发表于 Nature Communications。 清华大学电子工程系博士后周天贶和博士生姜一洲为该工作的共同第一作者,方璐教授为通讯作者。该研究得到科技部重大项目、基金委杰青项目、中国科协青托项目的支持。

论文链接:https://www.nature.com/articles/s41467-024-52418-y

供稿|信息认知与智能系统研究所

编辑|陶旋姿

审核|汪 玉 沈 渊 李冬梅